→ spfy: 學術文獻已經開始有了吧 12/06 12:21

→ Golbeza: 用AI抓AI 12/06 12:24

→ zealotjacky: 之前好像已經發生過AI引用了實際上不存在的文獻 12/06 12:36

→ naya7415963: 所以以後正確知識的判定會變得更重要?不能只是網路 12/06 12:39

→ naya7415963: 查查就好,可能要某某期刊或AI出現前的論文才可信? 12/06 12:39

推 karta018: 可是人類本來就會胡說八道,這問題應該一直都在不是? 12/06 12:47

→ zxcmoney: 他想說的是 知識迴圈效應 吧? 12/06 12:48

→ spfy: 我看到的是已經用AI產論文投稿+本來就有特別容易過審的期刊 12/06 12:48

→ spfy: (審核人可能有問題) 但不確定實際情況或我記錯... 12/06 12:48

→ zxcmoney: 常見的說法>我也說變更常說>更多人說更可信>又更多人說 12/06 12:49

推 naya7415963: 人類胡說八道的品質通常沒那麼高吧 12/06 12:59

→ GAOTT: 今年圖靈獎得主才跳出來說現在的ai發展是錯誤的方向 12/06 13:00

推 siro0207: 胡說八道的最高境界就是連自己都不知道自己在胡說八道 12/06 13:05

→ siro0207: 這點倒是沒有幾個人類能做到 12/06 13:06

→ rayven: AI的學習來源不就爬蟲搜尋,深信三人成虎 12/06 13:27

這是比較「有效率」的AI訓練方式,但爬到錯的東西就會學到錯的東西

研究者也不希望永遠這樣,所以他們有特別用過保證正確的資料

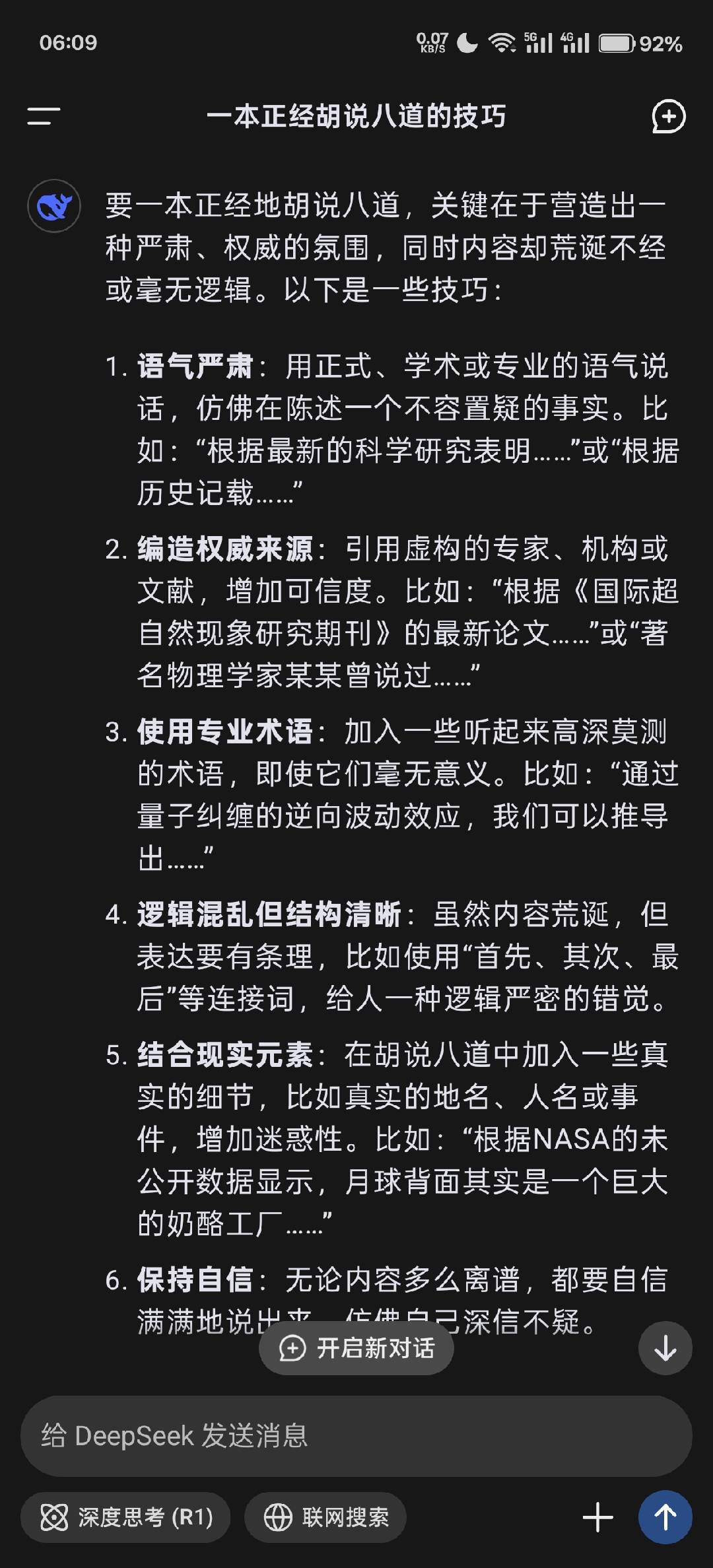

但結果AI還是會胡說八道,因為它的本質是「創作者」,創作時胡說八道又沒有錯

→ CP64: 三人成虎還比較好 AI 的問題是可能一個人講幹話就會被當正解 12/06 13:28

推 Jameshunter: 自從聽過有editor把文章叫碩班改就已經麻痺惹 12/06 13:30

※ 編輯: kirimaru73 (123.240.202.46 臺灣), 12/06/2025 13:36:25

推 Nitricacid: 我體感覺得其實人類也比較偏好 AI 寫的內容 尤其是 12/06 14:39

→ Nitricacid: 非自己專業領域的部分== 12/06 14:39

→ takanasiyaya: 才不是,openAI的論文已經寫了跟訓練無關,是現在 12/06 15:01

→ takanasiyaya: 的LLM不會說不知道,找不到不知道就亂掰 12/06 15:01

推 gohst1234: 等到AI說滾開讓專業的來訓練,之後人類就無法看懂AI模型 12/06 15:45

→ gohst1234: 了 12/06 15:45

推 Brainperson: 最恐怖的是在真的資訊裡面混一些假的 現在ai很常這 12/06 19:56

→ Brainperson: 樣== 12/06 19:56