推 Boris945: 可以用DirectML跑 效能約1/5而且很難搞150.117.168.178 07/20 22:24

→ spfy: 這個有掛AMD合作夥伴 把AI繪圖又包了一層UI118.231.169.100 07/20 22:27

→ spfy: 懶人簡單化 但預設模型有問題 畫出來超醜118.231.169.100 07/20 22:28

→ spfy: 至於你要性能差距的研究 建議自己研究118.231.169.100 07/20 22:28

推 rail02000: stable diffusion在AMD可以用ROCm 114.38.17.21 07/20 22:33

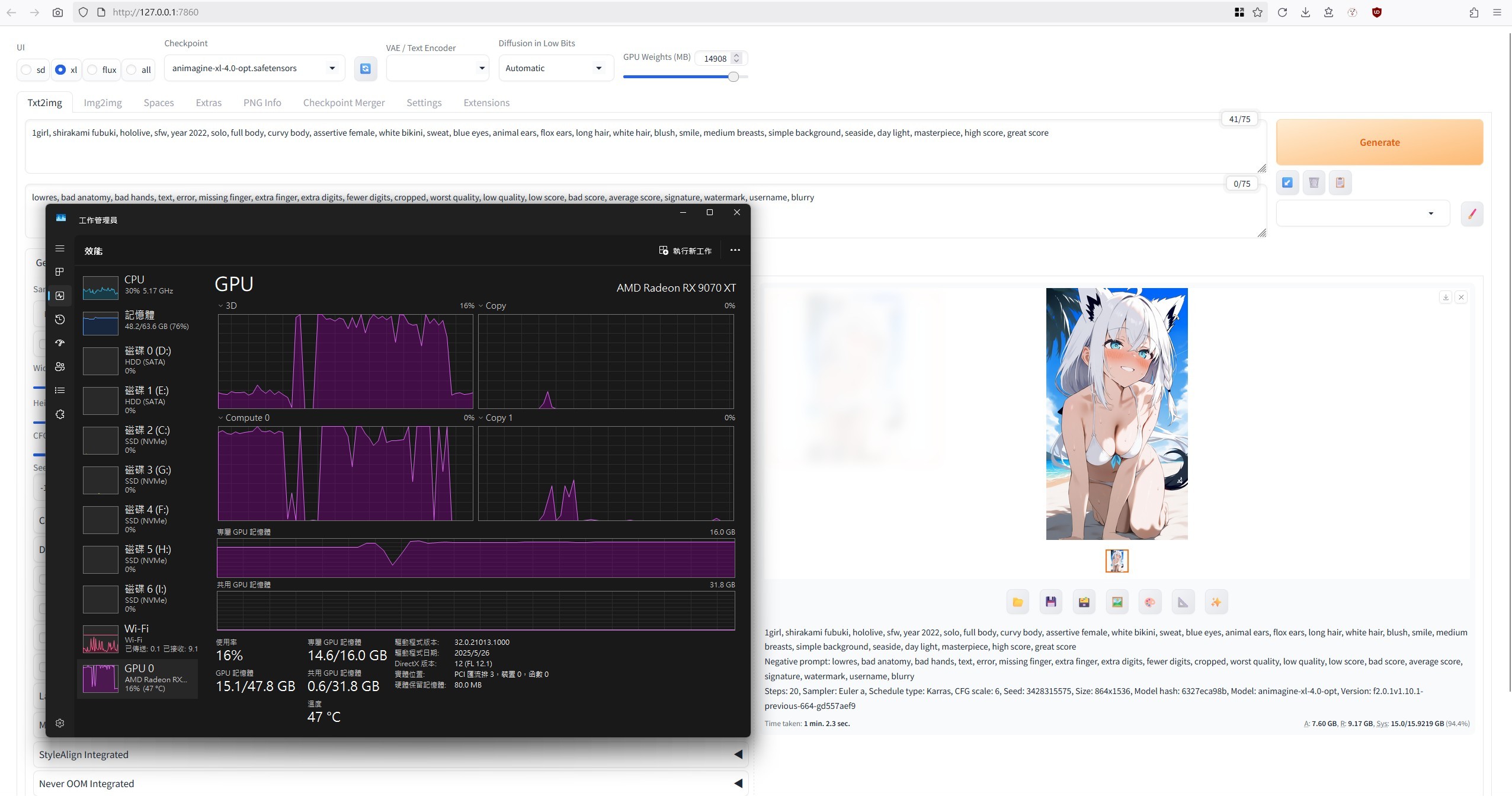

→ Pixmi: 9070XT可以跑得 36.237.238.204 07/20 22:37

推 tokikaze: directml,rocm,zluda,願意折騰辦法多得 36.236.224.31 07/20 22:41

→ tokikaze: 是 36.236.224.31 07/20 22:41

推 michellehot: 6700以上就可以了 但是速度很慢 118.232.100.61 07/20 22:41

→ michellehot: 而且要在Linux下用ROCm Win可能會當 118.232.100.61 07/20 22:42

推 jhjhs33504: 晶片還是很缺 Compute0動得起來就不錯 1.162.79.2 07/20 22:43

→ michellehot: 如果手癢跑圖去撿二手3060 12G就好 118.232.100.61 07/20 22:44

→ michellehot: 很多模型優化到6G 8G VRAM都跑的來 118.232.100.61 07/20 22:45

→ michellehot: 但是ㄧ換AMD就全崩了 至少目前是 118.232.100.61 07/20 22:46

→ michellehot: 9070xt跑圖速度之前有人分享過還行 118.232.100.61 07/20 22:47

推 Supasizeit: 你想知道什麼 差幾千塊不值得折騰203.204.195.174 07/20 22:48

推 dos01: 只問可不可以跑 答案是可以210.209.164.247 07/20 22:52

→ dos01: 但如果要問該不該買A卡來跑 只能說別這樣210.209.164.247 07/20 22:52

→ dos01: 搞自己210.209.164.247 07/20 22:52

→ vsbrm: 有AI需求就選N卡就別折騰自己了 1.175.89.237 07/20 23:03

推 doomsday0728: 除非你有一定技術力 不然乖乖買N卡 36.234.244.247 07/20 23:15

推 rgo: 蘇媽炒股比較利害 4月低點到現在 AMD+80% NVD 1.162.124.8 07/20 23:20

→ rgo: A+70% 1.162.124.8 07/20 23:20

→ commandoEX: rocm目前不支援windows吧,只能在WSL118.171.172.239 07/20 23:41

→ commandoEX: 下跑,要不然就要等7.0118.171.172.239 07/20 23:42

推 s78513221: win的ROCm停擺很久了,管生不管養 111.71.58.216 07/21 00:01

推 qwe753951: 別浪費時間111.241.189.121 07/21 00:06

→ Pixmi: windows環境跑ROCm 6.4以上版本要用WSL跑 36.237.238.204 07/21 00:08

→ CrackedVoice: 速度慢算小問題了,問題在其地方 1.162.128.97 07/21 00:30

→ CrackedVoice: 上網花更多時間搜尋解決問題的方式 1.162.128.97 07/21 00:31

推 langeo: amuse很爛很難用 18禁關不掉 1.163.145.243 07/21 00:38

→ gbcg9725: 有跑AI就別折騰A卡 技術一直在迭代 119.14.217.132 07/21 01:02

→ gbcg9725: 現在的能用不代表新的能用 119.14.217.132 07/21 01:02

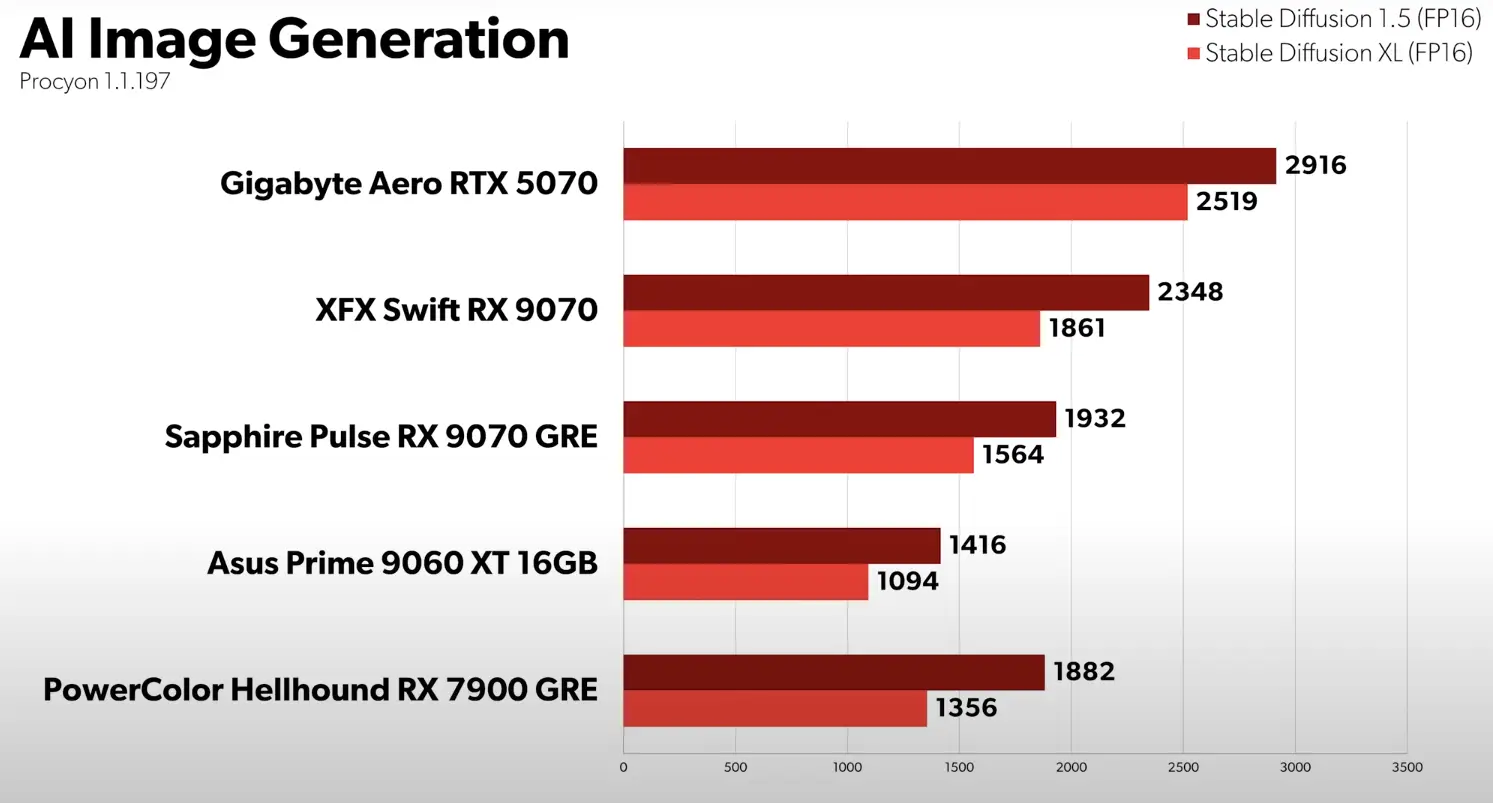

推 nextpage: 現在有些模型還針對5系做加速優化,速度 114.38.220.45 07/21 01:05

→ nextpage: 差距拉大你不得不屈服老黃淫威 114.38.220.45 07/21 01:06

推 arnold3: 看你願不願意自己寫代碼阿 182.234.98.55 07/21 03:10

推 Xpwa563704ju: 大部分AI的模型都是偏向N家的吧 42.74.24.248 07/21 05:37

推 ltytw: 都可以跑 但還是cuda優化最好 社群大小問 114.33.46.227 07/21 07:18

→ ltytw: 題 114.33.46.227 07/21 07:18

推 xsdferty035: 不要虐待自己 42.72.236.96 07/21 07:30

→ x94fujo6: 有CUDA的可以試試ZLUDA 114.33.176.49 07/21 08:01

→ zo6596001: 等2027年出的卡吧,預計會有架構調整 111.71.75.50 07/21 08:14

→ zo6596001: ,ROCm支援度可能會提高 111.71.75.50 07/21 08:14

→ zo6596001: 我比較期待架構調整後的Ryzen AI,共 111.71.75.50 07/21 08:16

→ zo6596001: 享記憶體非常大 111.71.75.50 07/21 08:16

推 yangwen5301: Win現在ROCm改用pip install了,GitH 106.146.12.229 07/21 09:20

→ yangwen5301: ub theRock有安裝步驟很容易 106.146.12.229 07/21 09:20

→ yangwen5301: 但只有6000和7000系 106.146.12.229 07/21 09:21

→ d58974: 必須得說,能跑,但要在win環境下很麻煩,不220.128.131.141 07/21 09:34

→ d58974: 像N卡網路一堆github專案可以一鍵安裝220.128.131.141 07/21 09:34

→ cc10601cc: 之前玩了一下 瞎搞一天後放棄了 49.216.48.13 07/21 09:40

推 elvis222: 我自己實試可以跑 但要用wsl安裝rocm 89.117.42.78 07/21 10:42

→ elvis222: 或者等一下rocm7 第三季上會有windows 89.117.42.78 07/21 10:42

→ elvis222: 版本 89.117.42.78 07/21 10:42

推 poi96300: 去撿張二手30系 都比你在那邊折騰還快 223.138.244.59 07/21 11:51

推 coox: 這要看社群實力 N家模型多太多了 163.26.206.202 07/21 12:04

推 benen: 欸黑~想要色色的話,成本多一點沒關係啦~ 101.8.137.137 07/21 12:06

→ benen: 不要省不要省☺♥(誤 101.8.137.137 07/21 12:06

推 qaz13579: 有AI需求就別折騰自己 123.205.15.239 07/21 12:20

推 forever9801: 7F那樣要一分23秒 那真的差距超大 118.165.11.114 07/21 13:23

→ forever9801: 更正 1分2秒 3080大概可能10秒 118.165.11.114 07/21 13:24

推 bala045: 別虐待自己 125.227.13.49 07/21 15:32

→ rail02000: Linux下裝ROCm不難,Stable Diffusion 111.83.189.236 07/21 18:39

→ rail02000: 也有一鍵安裝script+網頁前端。問題卡 111.83.189.236 07/21 18:39

→ rail02000: 在需要注意Python版本。 111.83.189.236 07/21 18:39

推 SecondRun: 不要再被跑分騙了118.167.228.155 07/21 18:45

→ NanaMizuki: 有ai需求就買nv118.170.198.197 07/21 22:22

→ lover19: 可不可以問候別人父母,可以,但你要付 42.70.2.184 07/22 09:19

→ lover19: 出代價 42.70.2.184 07/22 09:19