推 e04bank: 不要問....很恐怖...... 08/06 09:43

推 corum68972: 沒記錯的話google早就有對雲端掃照片了 08/06 09:45

推 roger840410: 當然是找一堆兒童色情照來training (x 08/06 09:48

→ ians0606: 我也覺得是欸 因為要建立database首先就要找到那些兒童 08/06 09:51

→ ians0606: 色情照片XD 08/06 09:51

推 suichui: 不知道二次元的算不算 08/06 10:09

推 pm2001: 技術上哪有甚麼問題 就圖樣辨識阿 08/06 10:31

→ Xperia: ??? 08/06 10:47

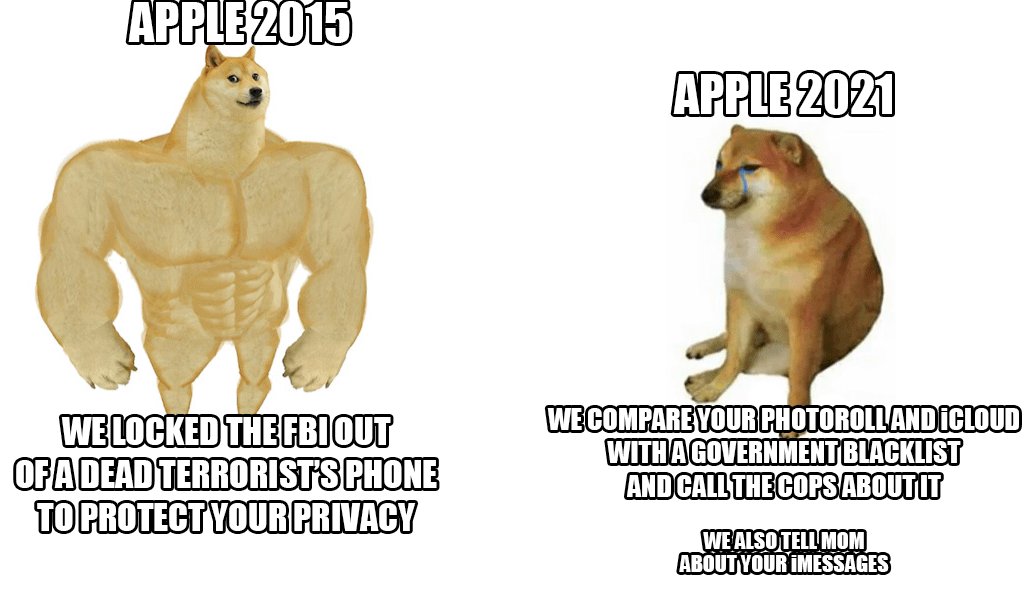

→ Xperia: 還以為蘋果一直是站在隱私至上的立場 08/06 10:48

→ xBox1Pro: 這要跟我百度雲上的h漫被刪掉一樣了 08/06 11:01

→ PopeVic: 可以參考官方技術文件,蘋果並不是單純的用影像辨識的方 08/06 11:47

→ PopeVic: 式來偵測,而是在本機取得圖片的 NeuralHash 值後再跟資 08/06 11:47

→ PopeVic: 料庫中的 hash 值比對,且比對的動作也是在本機執行。比 08/06 11:47

→ PopeVic: 對的結果也會經過加密後才會上傳到 iCloud,直到達到一 08/06 11:47

→ PopeVic: 定的閥值後蘋果才會解密並回報給 NCMEC。 08/06 11:47

推 LonyIce: 自拍影片怕怕 08/06 11:52

推 kyleJ: 看起來是只針對上傳到雲端的照片檢查?Google倒是先部署 08/06 11:54

→ kyleJ: 這個功能了 08/06 11:54

推 pm2001: 一樣阿 影像辨識原理也是取出特徵再做比對 08/06 11:54

→ gonna01: 美國法規的規定吧 08/06 12:38

推 chennylee809: 為了極少數的犯罪分子 監控全使用者 08/06 15:41

→ chennylee809: 既環保之後 隱私也變笑話了 08/06 15:41

→ PweDiePot: 影像辨識技術越來越強大了 08/06 16:17

推 cmchiu: 這就影像辨識的其中一種... 08/06 17:18

→ fufu8aa: 只差在圖片不會被真的上傳 08/06 18:27

推 cevs: 笑了 還主打隱私 08/06 18:34

推 dieangel006: 看個本子就出事了 08/06 18:47

推 flosser: 跟中國網盤刪掉我的A片庫87%像。 08/06 19:21

推 Bosung: 跟google雲端一樣吧 08/06 21:42

推 ho83leo: 推Pop 08/06 21:56

推 willschlafen: 不是 要怎麼知到是不是兒童的? 08/06 22:20

→ LonyIce: 先用一堆兒童犯罪圖片讓它學習就知道了 08/06 22:41

推 PopeVic: 回36樓,這點就是差別之一,蘋果並不是用分類模型來判斷 08/06 23:45

→ PopeVic: 圖片「像不像」兒童色情,神經網路只是用來提取圖片特徵 08/06 23:45

→ PopeVic: 值,再經過雜湊之後與「已知的」非法圖片進行比對,所以 08/06 23:45

→ PopeVic: 判斷的方式是看有無與已知的圖片「近乎相似」。它的概念 08/06 23:45

→ PopeVic: 比較類似以圖搜圖,而不 google 相簿的場景辨識。故重點 08/06 23:45

→ PopeVic: 在於已知的資料庫內容,理論上要明確被列入資料庫的非法 08/06 23:45

→ PopeVic: 照片才會觸發閥值。 08/06 23:45

推 berserkman: 需要好好了解一下蘋果和google照片辨識的差異 08/07 00:53

噓 fostertaz: 結果一堆家長拍小孩游泳被誤報就好笑了。 08/07 06:14

推 Koibito: 隨便加個浮水印或裁一下邊,照片Hash值應該就變了,無法 08/07 07:54

→ Koibito: 辨識了吧? 08/07 07:54

推 yahappy4u: 這真的有點難,隱私與兒童安全的拿捏 08/09 05:33

→ yahappy4u: 但應該可以用不一樣的方法維護兒童安全,不應這樣侵害 08/09 05:43

→ yahappy4u: 隱私 08/09 05:43

推 neil25: 發育不良的女朋友被當兒童 蘋果認證了 08/11 09:28